SK Hynix enthüllt 16-lagigen HBM4-Speicher für KI-Superchips

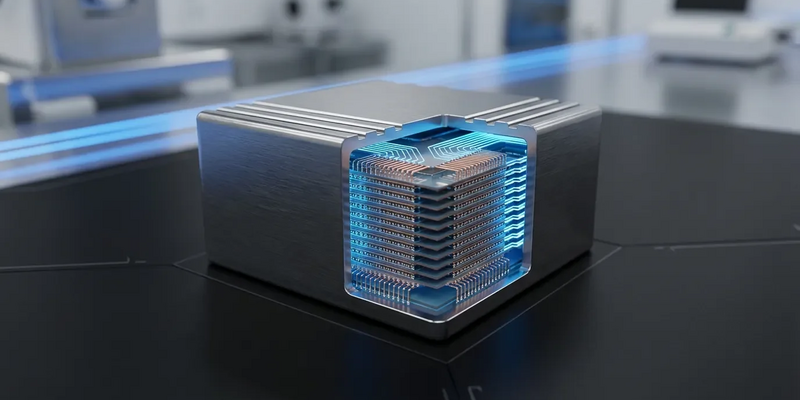

14.01.2026 - 23:01:12SK Hynix setzt mit der Vorstellung seines bahnbrechenden 16-lagigen HBM4-Speichers auf der CES 2026 einen neuen Maßstab für KI-Hardware. Der Speicher mit 48 Gigabyte Kapazität und einer Bandbreite von über 2 Terabyte pro Sekunde soll die nächste Generation von KI-Beschleunigern antreiben – und festigt die Marktführerschaft des südkoreanischen Konzerns im hart umkämpften HBM-Markt.

Neuer Leistungsrekord für KI-Systeme

Das vorgestellte Modell übertrifft seine Vorgänger deutlich. Gegenüber dem 12-lagigen HBM4 mit 36 GB steigert die neue 16-Hi-Stapelung sowohl Kapazität als auch Datendurchsatz entscheidend. Mit einer Transferrate von bis zu 11,7 Gigabit pro Sekunde pro Pin und einer 2.048-Bit-Schnittstelle knackt ein einzelner HBM4-Stapel die 2-TB/s-Marke. Das ist fast das Dreifache der Leistung früher HBM3-Generationen, die den ersten Generative-AI-Boom ermöglichten.

Ein weiterer Schlüsselfaktor: die Energieeffizienz. Sie soll um über 40 Prozent gegenüber der vorherigen Generation gesteigert sein. Für Rechenzentren mit explodierendem Stromverbrauch durch KI-Workloads ist das ein entscheidendes Argument.

Passend zum Thema KI-Hardware: Seit August 2024 gelten neue EU-Vorgaben zur KI, und viele Unternehmen sind unsicher, welche Kennzeichnungs‑ und Dokumentationspflichten für ihre Systeme gelten. Dieses kostenlose E‑Book erklärt kompakt, wie Sie KI‑Systeme korrekt klassifizieren, welche Nachweise und Prozesse jetzt gefordert sind und welche Fristen auf Entwickler sowie Rechenzentrumsbetreiber zukommen. Mit praktischen Vorlagen und Prüflisten, die Ihnen die Umsetzung erleichtern. KI-Verordnung E-Book jetzt downloaden

Hochleistungs-Packaging und Schlüsselallianz mit TSMC

Die hohe Stapelung stellt immense technische Herausforderungen. Ermöglicht wird sie durch ein proprietäres Packaging-Verfahren namens Mass Reflow Molded Underfill (MR-MUF). Dabei werden die DRAM-Wafer auf nur 30 Mikrometer verdünnt, um alle 16 Lagen im standardisierten Bauraum von 775 Mikrometern unterzubringen.

Strategisch bedeutsam ist die Partnerschaft mit dem taiwanischen Chiphersteller TSMC. Für die Basis-Logikschicht des HBM4-Stapels nutzt SK Hynix einen 12-Nanometer-Fertigungsprozess von TSMC. Diese Logikschicht steuert Stromversorgung und Signale – ihre Performance ist zentral für die Effizienz des gesamten Moduls. Die Kooperation unterstreicht einen Trend: Der HBM-Speicher wird vom passiven Bauteil zum aktiven, logikintegrierten Teil des KI-Prozessors selbst.

Treibstoff für Nvidias nächste GPU-Generation

Hauptabnehmer der neuen Speichergeneration werden die kommenden KI-Beschleuniger sein. Branchenkreise erwarten, dass SK Hynix’ HBM4 Kernkomponente in Nvidias nächster GPU-Plattform „Rubin“ sein wird, dem Nachfolger der aktuellen Blackwell-Architektur. Der immense Bedarf an Speicherbandbreite von KI-Pionieren wie Nvidia hat die Entwicklung von HBM4 massiv beschleunigt. Berichten zufolge drängen große Kunden auf aggressive Zeitpläne und immer höhere Leistungsspezifikationen.

Neben dem Flaggschiff HBM4 präsentierte SK Hynix auf der CES ein Portfolio weiterer spezieller KI-Speicher. Dazu gehören das stromsparende SOCAMM2 für KI-Server, LPDDR6 für On-Device-KI in Smartphones und ein 321-lagiges QLC-NAND mit 2 Terabit für Hochkapazitäts-SSDs in KI-Rechenzentren.

Härtester Wettbewerb im HBM-Markt

Die Enthüllung fällt mitten in den „HBM4-Memory-Krieg“. SK Hynix hält derzeit mit über 50 Prozent Marktanteil die Spitzenposition im globalen HBM-Geschäft. Doch die Rivalen Samsung und Micron entwickeln aggressiv eigene HBM4-Lösungen, um sich Großaufträge der KI-Chipdesigner zu sichern. Alle drei Hersteller feilen angeblich an ihren Designs, um den strengen Anforderungen von Nvidia für die Rubin-Plattform zu genügen.

Samsung gibt an, dass Kunden die Wettbewerbsfähigkeit seiner kommenden HBM4-Chips gelobt hätten. Micron hat bereits Musterexemplare an Kunden ausgeliefert und baut seine Fertigungskapazitäten aus. Der immense Kapitalaufwand und das technologische Know-how, die für diesen Wettbewerb nötig sind, zeigen: HBM-Speicher ist kein Commodity mehr, sondern ein strategischer Schlüsselbaustein für die Zukunft der KI.

Produktionsstart für das dritte Quartal 2026 geplant

Die Entwicklung des 16-lagigen HBM4 verlaufe planmäßig, so SK Hynix. Die Massenproduktion soll im dritten Quartal 2026 anlaufen. Um den erwarteten Nachfrageschub zu bedienen, investiert das Unternehmen massiv in seine Infrastruktur. Geplant ist unter anderem der Bau der weltweit größten HBM-Montage- und Testanlage in Südkorea, deren Bau im April 2026 beginnen soll.

Während KI-Modelle immer komplexer werden, verlagert sich der Engpass von der reinen Rechenleistung hin zu Speicherbandbreite und Effizienz. Der 16-lagige HBM4 ist ein entscheidender Enabler für die nächste KI-Generation – ob für große Sprachmodelle oder wissenschaftliche Simulationen. Die Fortschritte dieser Woche machen klar: Der Speicher ist zum Taktgeber des technologischen Fortschritts im KI-Zeitalter geworden.

PS: KI-Workloads erhöhen nicht nur Leistungsanforderungen, sondern auch die Angriffsfläche für Cyberkriminelle und Ausfallszenarien in Rechenzentren. Dieser kostenlose Cyber-Security-Report zeigt konkrete Schutzmaßnahmen für KI-Infrastruktur, von Zugangskontrollen über Netzwerksegmentierung bis zu Notfallplänen, und liefert eine Checkliste für IT‑Leiter, die Rechenzentren und KI-Cluster absichern möchten. Inklusive praktischer Handlungsempfehlungen und Compliance-Hinweisen. Cyber-Security E-Book gratis herunterladen